AI-tools hebben in korte tijd hun weg gevonden naar de creatieve industrie. Voor tekst, beeld en zelfs video zijn er inmiddels krachtige AI-tools beschikbaar. Maar hoe zit het met motion design? In dit artikel neem ik je mee in wat er nu kan met AI-tools én waarom menselijke creativiteit en expertise voorlopig onmisbaar blijft.

Wanneer spreek je van een AI-tool?

De AI-tools, -termen en prompts vliegen je om de oren, maar wanneer heb je nou écht te maken met een AI-tool? Als je een prompt invult, ja. Maar bij generatieve AI is dat niet altijd nodig. Veel plug-ins en programma’s noemen zichzelf AI, terwijl dat technisch gezien niet zo is. Dus, voor alle duidelijkheid: in dit artikel gaan we uit van het volgende.

Iets is een AI-tool als het…

… patronen herkent of leert van data (oftewel: machine learning)

… zelfstandig beslissingen neemt of voorspellingen doet

… nieuwe content genereert op basis van input

… input en output op een slimme manier met elkaar verbindt, die verder gaat dan simpele automatisering

Met deze definitie zie je meteen het verschil tussen tools die écht AI inzetten en tools die vooral slimme automatisering zijn. Ik neem je mee in wat deze tools betekenen voor motion design.

Wat betekent AI voor de workflow?

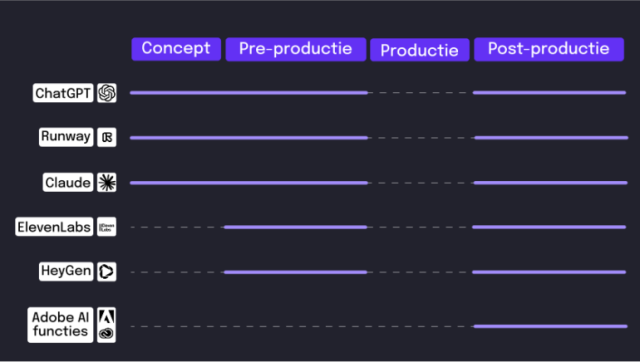

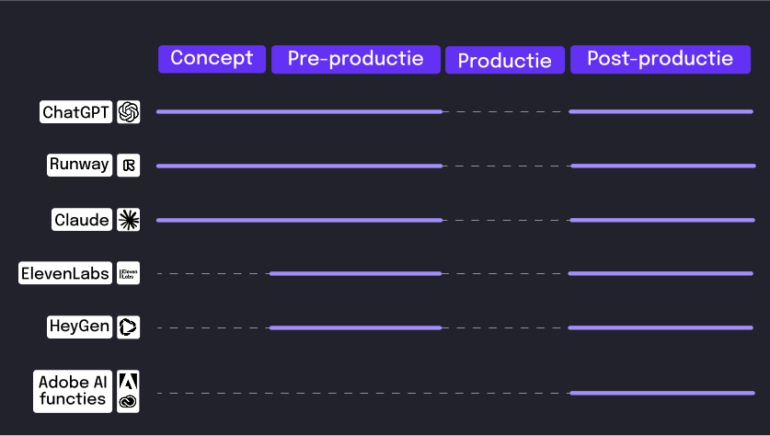

Om goed uit te leggen wat AI nu betekent voor motion design, neem ik je eerst mee in de huidige workflow. Waar in het proces gebruiken we welke tools, en waar nog niet?

Want let op: er komen razendsnel nieuwe AI-tools bij. Wat vandaag nog mensenwerk is, kan morgen zomaar door een slimme tool overgenomen worden. De rol van AI in motion design is dus niet in beton gegoten, en kan snel veranderen. Let’s break it down:

Binnen een digitaal bureau als Goldfizh is AI duidelijk niet meer weg te denken uit onze workflow. Van ChatGPT voor teksten tot Runway voor beeldgeneratie en Elevenlabs voor voice-overs: we gebruiken het allemaal. Maar je ziet het: de productiefase heeft geen AI-hulpje. Hoe zit dat?

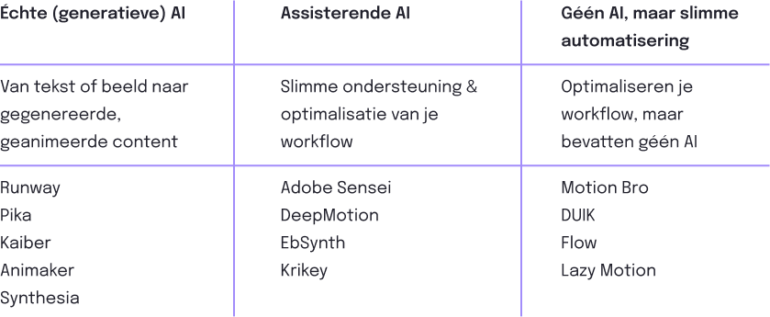

Welke motion ‘AI-tools’ zijn er nu beschikbaar?

In de basis kun je het (AI-)landschap voor motion designers in drie secties verdelen. Tools die het werk voor je doen, tools die jou ondersteunen, en tools die helemaal geen AI bevatten.

Er zijn dus wel degelijk AI-tools voor motion designers. Waarom gebruiken wij die niet in de productiefase? Het zit ‘m in het soort AI, dus het soort input en output. Text-to-text? Werkt als een tierelier. Ook text-to-image, image-to-video en zelfs voice-cloning zijn in de afgelopen jaren snel ontwikkeld. Maar prompt-to-animation? Dat blijft nog even uit.

Wat er wél is, is LottieFiles Copilot. Hier kun je lichte, schaalbare animaties mee maken en implementeren in app en web. De animaties zijn gebaseerd op het Lottie-formaat, een JSON-gebaseerde structuur die animaties uit Adobe After Effects omzet naar code die snel rendert op verschillende apparaten. Dit kan handig zijn voor UX-motion, maar voor motion in video of motion branding is dit (nog) niet van meerwaarde voor mijn werkproces.

I’ve found it not useful for any creative work yet. […] I could not imagine it taking over advanced coding, design, or nuanced motion treatment where an eye for detail and following direction is required. – Stephen Ong, freelance motion designer

Wat ontbreekt er?

Een groot deel van de ‘AI for animation’ tools die nu op de markt zijn, worden gebruikt voor fictieve of absurdistische beelden. Leuk om mee te experimenteren, maar niet per se wat ik zoek voor mijn alledaagse werk.

Bron: https://klingai.com/global/

Het ontbreekt namelijk aan een aantal belangrijke elementen:

1. Controle

Motion design is meer dan alleen beweging. Collega Eveline zei het al: motion is een essentieel onderdeel van je branding. Ook in UX speelt motion een steeds groter wordende rol. Het gaat om timing, emotie, stijl en precisie. Dit is simpelweg nog te ingewikkeld voor de huidige tooling.

2. Bewerkbaarheid

Veel van bovenstaande tools leveren video-output, maar zonder gelaagdheid. Hier heb je dus geen toegang tot de onderliggende animatie lagen. Je kunt dus niet ‘even’ een timing of ease aanpassen. Dit maakt finetunen onmogelijk, terwijl motion juist maatwerk is.

3. Generiek resultaat

Hoe verrassend soms ook, vaak ziet de output van AI eruit als een mix van wat er al bestaat. Branded content, maar ook onderscheidende bewegingsstijlen of unieke karakteranimaties maken is lastig. Enne… consistentie tussen de scènes? Dat is nog ver weg.

4. (Geen) geavanceerde opties

Punt twee benoemt het al, maar de output is vaak één ‘laag’. Dit houdt in dat je dus niet zomaar iets (bijvoorbeeld een los element de positie daarvan) kunt tweaken of bewerken, maar ook dat er geen mogelijkheid is voor geavanceerdere composities met bijvoorbeeld 3D-ruimtes, parenting of expressies. De expertise ontbreekt dus!

Om een beeld te geven, heb ik geëxperimenteerd met verschillende tools en prompts. Ik uploadde een afbeelding van een vlinder en vroeg simpelweg: laat deze vliegen. Hieronder zie je per prompt en iteratie wat dat opleverde:

Niet echt natuurgetrouw, toch? De beweging klopt niet, de vlinder verdwijnt deels uit beeld, en is overall niet echt overtuigend. Bovendien is dit dus één laag. De timing kan ik bijvoorbeeld niet aanpassen.

Dat moet anders! Hieronder een kijkje in de keuken: hoe pak ik dit aan? De grootste verschillen:

- Losse lagen: ik haal elk element los van elkaar, zodat deze apart kunnen bewegen. Dit houdt in dat ik het lijfje, de linker- én rechtervleugel allemaal los van elkaar laat bewegen.

- Lagen bundelen: door deze lagen te bundelen in een zogeheten pre-comp, kan ik extra gelaagdheid aan de beweging toevoegen. De vlinder beweegt niet alleen van rechts naar links, maar komt ook dichterbij. Deze scherptediepte-laag voegt een extra dimensie toe!

Wat kunnen we wél verwachten van AI in motion?

Waar motion designers nu hooguit een expressie laten genereren, houden Google DeepMind en Meta AI zich bezig met onderzoek naar prompt-to-animation technologieën:

1. Google DeepMind – Veo 2

Veo 2 is een geavanceerd AI-model dat video’s kan genereren op basis van tekstprompts. Het model snapt hoe dingen bewegen en volgt je instructies verrassend goed, zelfs met verschillende camerahoeken.

2. Google DeepMind – Motion Prompting

Schrik niet, deze is wat technischer: Motion Prompting is een techniek waarbij bewegingsprompts worden gebruikt om video-animaties te sturen. Zo kun je bepaalde objecten of scènes aansturen, net zoals je een tekstmodel opdrachten geeft.

Maar, nog even geduld: deze zijn nog niet commercieel beschikbaar of praktisch bruikbaar voor professionele workflows.

Dus, motion en AI: een match?

Misschien eerder een beginnende liefde. Op dit moment is AI een handige ondersteuning om sneller en efficiënter te werken, maar zie het als een persoonlijke assistent, geen collega. 😉 AI ontwikkelt razendsnel, dus wie weet wanneer prompt-to-animation wél beschikbaar is.